Teknologi med f.eks. JavaScript kan forhindre optimal indeksering på Google

Det er blevet “in” og smart i dag at anvende nye teknologier i forbindelse med udarbejdelse af hjemmesider og webshops.

Søgemaskiner som Google, Bing og Yahoo anser brug af JavaScript-baserede løsninger som et større problem og kommer med løsningsforslag på problemet med crawling af websites med JavaScript og indekseringsproblemer.

Problemet med at anvende teknologier, som f.eks. JavaScript, kan være, at man risikerer at få en hjemmeside, der tidligere rangere godt på Google og har opnået mange gode placeringer i søgeresultaterne, til at forsvinde og miste sin organiske trafik.

Dette kan blive et større problem, især hvis man har en hjemmeside eller webshop med f.eks. 50.000 eller flere organiske besøg om måneden, og man mister 80-90% af denne trafik. I praksis betyder det, at man bliver nødt til at kompensere ved at købe trafik, f.eks. gennem Google Ads, for at opretholde samme niveau af kundetilstrømning.

Du har sandsynligvis en idé om, hvor meget det koster gennemsnitligt pr. besøg med Google Ads, baseret på din egen branche. Ved at gange dette tal med det antal manglende organiske besøg, kan du danne dig et indtryk af, hvor dyrt det kan blive at overse vigtigheden af valg af kodningsteknologi, der ikke er optimal i forhold til søgemaskiner.

Er din virksomhed klar til at tage chancen uden SEO-rådgivning og gennemgang af din webløsning?

Fra Google blog

Sometimes things don’t go perfectly during rendering, which may negatively impact search results for your site.

JavaScript baserede websites

Fordele:

- Smarte webløsninger

- Dynamiske effekter og elementer

- Gode muligheder for lækre design

- PWA Apps – progressive web Apps

Ulemper:

- Koden skal eksekveres først i modsætning til html af Google bot

- Længere indekseringstid qua koden hentes og eksekveres senere vha. en Google Chrome browser version.

- Sitet sættes i kø for senere rendering efter koden er hentet af Google bot, og kan ikke umiddelbart testet i Serps før denne redering har fundet sted, hvor noget af koden kan ses i Google cache straks og JavaScript koden ikke kan ( Kører ikke i Sync) (der kan gå fra kort tid til flere måneder før den har renderet siden).

- Fejl i kodning opdages ikke kontinuerligt, men kommer i takt med sites bliver renderet

- Når siden opdateres, så går der renderingstid igen, hvor gammelt indhold anvendes til ranking af den pågældende side

Hvordan fungerer JavaScript?

JavaScript er en af de grundlæggende webudviklingsteknologier.

HTML anvendes i forbindelse med kodning af statiske sider. Browseren læser koden, som den er gengivet og kan ikke ændres ud fra brugerens handlinger.

JavaScript er dynamisk og kan ændres ud fra brugerens handling på websiden og værdier giver mulighed for andre handlinger.

Hvorfor er det problematisk med JavaScript?

Der opstår en situation, hvor søgemaskinerne ikke kan læse og forstå det samme indhold, som en bruger på websitet, der anvender en moderne browser, som fortolker alt det indhold , der anvendes klientside. Google anvender en Google Chrome browser version til renderingen. Google har længe fortalt at de snart kommer med en bedre metode / udgave, men er samtidig kommet med en anden løsning til større websites, der opdateres tit.

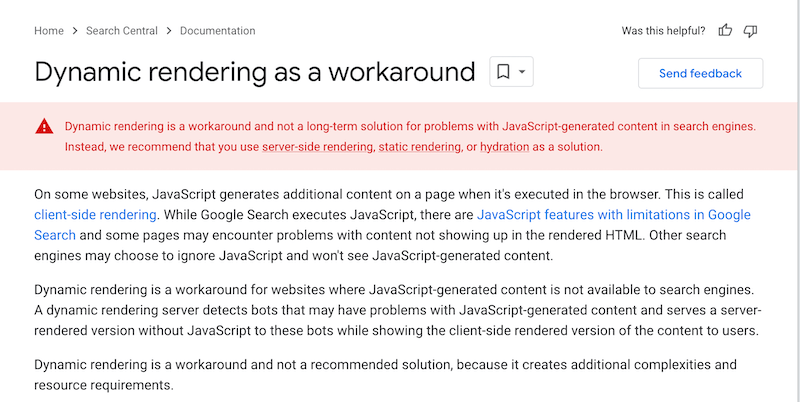

Google anbefaler dynamic rendering til visse typer websites

- Hvad er dynamisk rendering?

- Er der behov for dynamisk rendering

- Er der risiko forbundet med dynamisk rendering?

- Hvilke løsninger, er der til udførsel af dette?

Client-side og server-side rendering

Der er to former for rendering

- Rendering på serveren inden data leveres til browseren – Googlebot får det fulde overblik ved at downloade siden og tilhørende CSS filer.

- JavaScript, køres generelt på klientmaskinen (klientsiden), hvilket betyder at Googlebot henter siden, og så skaber JavaScript DOM (Document Object Model), der skal bruges til at indlæse det gengivne indhold.

Hvis Googlebot ikke kan udføre og forstå JavaScriptet korrekt på siden, så kan den ikke se det indhold, du ønskede Google skulle se. Det er her, hvor de fleste af problemerne med JavaScript og problemer i forhold til SEO stammer fra.

Typer af rendering

- Server-side rendering (SSR)

- Client-side rendering (CSR)

- Rehydration

- Prerendering

Selvom Google i dag foretrækker teknologierne CSR/Rehydration, så er Dynamisk rendering stadig godt og gennemtestet – og det virker i praksis uden problemer: Læs mere på developers.google.com

Hvornår bør jeg anvende f.eks. Dynamisk rendering?

- Store websites med mange opdateringer

- Social media sites

- Websites der jævnligt opdateres og hvor nyt indhold ønskes hurtigt indekseret

Sådan virker dynamisk rendering

At implementere dynamisk rendering kan være udfordrende både i forhold til ressourcer og tidsforbrug.

Processen med dynamisk rendering fungerer typisk ved at levere hele JavaScript versionen til brugerne og HTML-filerne til søgemaskine-robotter.

Her er de enkelte trin i den dynamiske rendering:

- En ekstern dynamisk renderer, som f.eks. Prerender.io, installeres på serveren for at identificere søgemaskine-robotter.

- Anmodninger fra robotter (crawlers) sendes til renderen, som fungerer som en oversætter af indholdet til noget, der passer til f.eks. Google bot (en statisk HTML-version). Denne version af siden bliver derefter gemt i cache til senere brug.

- Anmodninger fra menneskelige brugere håndteres normalt og sendes til websitet. Denne del af den dynamiske rendering kan også bruges til at bestemme, om brugerne skal have vist desktop- eller mobilindhold.

Denne teknik er ideel til store websites, der genererer meget indhold og opdateres jævnligt.

Er der tale om Cloaking?

Som uden tvivl en af Danmarks største IP-cloakere, kommer tanken straks til at dreje sig om, hvorvidt dynamisk rendering kan sammenlignes med Cloaking! Teknikken er stort set den samme, men formålet med dynamisk rendering er ikke det samme.

I Googles univers refererer “cloaking” til praksissen med at vise forskelligt indhold eller URL’er til brugerne og søgemaskiner som Google-bot. Dette blev tidligere anvendt til at manipulere søgemaskiner ved at vise en “fantastisk optimeret tekst” til søgemaskinerne, mens brugerne blev præsenteret for en mere indbydende tekst.

Google beskriver “cloaking” som metoden til at vise forskelligt indhold eller URL’er til brugere og søgemaskiner.

I Googles optik betragtes cloaking som en praksis inden for Black Hat SEO.

Selvom dynamisk rendering af indhold leverer forskellige versioner til begge grupper, bruges det primært for at sikre, at indholdet kan læses og forstås af søgemaskinerobotter.

Ved at vise det samme indhold i den renderede version til Google-bot og den almindelige version til brugere, kan Google nemt og hurtigt indeksere sitet uden problemer og indekseringsbarrierer.

Har I noget information om, når videoindhold ikke bliver indekseret?

Hej Janus

Ja, vi har kendskab til flere områder, hvor der ikke indekseres Video etc. men det kræver mere viden om det website du arbejder med.

Et hurtigt slag på tasken uden at kende dit website: Har du husket at sætte: max-image-preview:large, max-snippet:-1, max-video-preview:-1.